Les grands modèles de langage (LLM), comme ChatGPT d’OpenAI, deviennent des outils incontournables. Ils jouent un rôle crucial dans la transformation de divers secteurs, allant de l’ingénierie logicielle avec la création de code jusqu’au droit pour aider à la rédaction et à la recherche. Cependant, malgré leur utilité indéniable, ces modèles présentent des limites et des points d’attention qui méritent d’être connus et discutés. Cet article explore en profondeur les défis et les implications de l’utilisation de ces LLM, qu’ils soient techniques, éthiques ou environnementaux.

Des LLM pas forcément à jour

Pour obtenir un LLM de qualité, il est nécessaire d’avoir des données de qualité. Pour cela, il faut les sélectionner, les collecter, les nettoyer et les normaliser. Tout cela nécessite beaucoup de ressources (collaborateurs, outils, temps et donc argent). Cette collecte doit forcément s’arrêter à un moment donné. Pour GPT-3.5, les données les plus récentes datent de septembre 2021, et pour GPT-4, de janvier 2022. ChatGPT, n’étant pas connecté à Internet dans sa version gratuite, n’a accès qu’aux informations sur lesquelles il a été entraîné. Il ne peut donc pas récupérer de mises à jour telles que les derniers cours de la bourse, la météo ou des articles récents. Du fait de cette limitation, il est possible qu’il produise des informations incorrectes, inexactes ou fausses, car elles ne sont plus à jour. Cela a été amélioré avec GPT-4 Turbo, qui dispose de données allant jusqu’à avril 2023.

Prenons le cas d’un développeur qui génère du code via ChatGPT et qu’il reprend ce morceau de code pour l’inclure dans son logiciel. Il est probable qu’il ajoute une dépendance (librairie externe) à son projet qui n’est pas à jour. Cela peut poser plusieurs problèmes, comme :

- ne pas disposer des dernières fonctionnalités et améliorations ;

- entraîner des problèmes de standard et de compatibilité avec le langage de programmation ou d’autres dépendances ;

- ne pas profiter des meilleures performances possibles ;

- plus grave, avoir des failles de sécurité connues qui ont été corrigées dans les versions plus récentes.

Ce problème peut être contourné grâce à la version payant de ChatGPT vous permettant d’utiliser des plugins et permettant à ChatGPT d’accéder à internet. Certains plugins permettent d’utiliser des données issues de diverses sources comme des PDF, des APIs ou des sites web. Vous pouvez aussi fournir directement des informations au LLM dans votre prompt ou via l’upload de vos documents.

Limite des tâches complexes ou longue

Les LLM, comme ChatGPT, ne sont pas des experts. Ils sont compétents dans de nombreux domaines, mais n’excellent en rien. Il est possible de « fine-tuner » certains LLM. Le « LLM Fine-tuning » est le processus de ré-entraînement avec de nouvelles données afin de spécialiser le modèle à une tâche ou à une application spécifique. Cela permet d’obtenir des résultats plus précis et efficaces, sans y passer beaucoup de temps et sans dépenser beaucoup d’argent. Pour vous donner un exemple, il est possible de fine tuner un LLM pour un chat bot de support client en se basant sur les questions passées.

Aussi, ils ne sont pas doués pour résoudre plusieurs tâches en parallèle. Une contre-mesure palliative est d’aborder les problèmes étape par étape plutôt que de vouloir tout faire d’un coup. C’est la même chose lorsque vous lui demandez d’effectuer des tâches trop complexes. Utilisez des prompts plus courts et plus concis, et enchaînez-les les uns après les autres. Plus votre prompt est long et complexe, plus ChatGPT aura tendance à omettre certaines parties ou à répondre de manière incomplète. Vous pouvez aussi profiter du fait qu’avec ChatGPT, vous disposez d’une mémoire au sein d’une même conversation à laquelle le LLM peut se référer.

Les mathématiques ne sont pas leur domaine de prédilection

Un des domaines dans lesquels ChatGPT n’est pas performant sont les mathématiques et les problèmes d’arithmétique en général. Cela est dû à plusieurs raisons :

- Le manque de données sur les problèmes mathématiques lors de la phase d’entraînement ;

- La manière dont les LLM représentent et traitent les données, rende difficile la représentation et la manipulation des nombres ;

- Les problèmes d’algèbre requérant souvent plusieurs étapes et ils commettent des erreurs de ce fait ;

- Ils ne savent pas représenter et comprendre certaines notations mathématiques.

Je vous conseille de toujours vérifier les résultats de pourcentages ou d’opérations que vous auriez demandés à ChatGPT, ou d’utiliser des outils alternatifs. Il en existe plusieurs, tels que Wolfram Alpha, qui peut résoudre des problèmes mathématiques, ou Socratic, qui peut aider dans différentes tâches, y compris les mathématiques.

La fenêtre de contexte dans les LLM : un équilibre entre performance et ressources

La fenêtre de contexte est la quantité maximale de texte (mot ou token) que le LLM peut :

- utiliser pour le prompt et la réponse et à laquelle ;

- se référer pour garder un historique, avoir une certaine « mémoire » lors de discussions ;

- prendre en compte pour prédire le prochain mot.

Ce mécanisme est crucial pour la compréhension sémantique du texte, reconnaître la structure syntaxique des phrases, la désambiguïsation lexicale et pour maintenir une cohérence globale. Plus cette fenêtre est grande, plus elle améliore les points cités précédemment. Toutefois, plus elle est grande, plus il y aura besoin de ressources et de façon quadratique (c’est-à-dire de façon non linéaire, comme pour une voiture qui a besoin de beaucoup plus d’essence à mesure que vous accélérez). C’est un des défis actuels : avoir une taille de fenêtre assez grande pour éviter tout problème évoqué ci-dessus, tout en ayant un besoin de ressources raisonnable avec un temps de traitement raisonnable.

La dernière version de GPT, GPT-4 turbo, a un contexte de 128k tokens, représentant environ 300 pages, soit environ la taille d’un livre. En comparaison, la dernière version de GPT-4 avait 32k tokens, et Claude 2 d’Anthropic en a 100k. Pour en savoir plus, vous pouvez aller lire mon article précédent dans lequel j’explique cela plus en profondeur.

Hallucination

Les LLM, comme ChatGPT, produisent des textes convaincants qui semblent humains. Cependant, n’ayant ni expérience, ni croyance, ni opinion, ni conscience, ils ne peuvent fournir une réponse authentique. Ils sont capables de générer de fausses informations, des réponses inexactes ou absurdes, tant que cela semble plausible et convaincant.

On parle d’hallucination lorsque le modèle invente des éléments qui semblent plausibles, mais qui sont entièrement fictifs. Il peut générer des faits trompeurs, inventer des événements, faire de fausses allégations scientifiques, produire des inexactitudes historiques, inventer des personnes ou des personnages, ou créer de fausses citations.

Récemment, un avocat amériquain s’étant servi de ChatGPT pour constituer un mémoire juridique n’a pas suffisamment vérifié la véracité des informations générées. En conséquence, le LLM a créé de fausses affaires et de fausses citations qui semblaient vraies. La seule vérification de l’avocat a été de demander au LLM si c’étaient de vraies affaires… Ce à quoi ChatGPT a répondu par l’affirmative.

Pour vous prémunir de cela, je vous conseille de toujours vérifier les informations et les faits générés par ChatGPT. Une autre façon d’éviter les hallucinations est de pratiquer le « prompt engineering », c’est-à-dire d’améliorer ou d’adapter votre prompt en utilisant différentes techniques, comme l’ajout d’exemples, de contexte ou de persona. Soyez le plus clair et concis possible. N’hésitez pas aussi à préciser qu’il peut vous dire quand il ne sait pas quelque chose.

Ne cite pas les sources

Lorsqu’on pose une question à ChatGPT, il se contente de donner une réponse. Depuis peu, il cite les sources. C’était un manque qui ne permettait pas d’avoir une confiance élevée. Pour certaines réponses, il est possible qu’il ne cite pas ses sources.

Il y a deux solutions à ce problème. La première est de vérifier les faits avec un moteur de recherche. La deuxième est d’utiliser un plugin ou une application tierce qui effectue en amont une recherche sur internet, envoie les résultats à ChatGPT avec la question, et donne les URL des pages web utilisées lors de la réponse.

Quelle que soit la méthode utilisée, je vous conseille de ne pas placer une confiance absolue dans les réponses. J’ai récemment découvert perplexity.ia qui, en plus d’utiliser des modèles comme GPT-4 ou Anthropic 2, effectue des recherches sur internet et ajoute dans le résultat généré les liens vers lesquels il a trouvé les fragments de réponse, que ce soit au niveau du paragraphe, voire phrase par phrase.

Biais d’entraînement, amplification et empoisonnement des données

Un biais d’entraînement est un phénomène qui se produit lorsqu’un algorithme produit des résultats préjugés en raison d’hypothèses erronées ou de données déséquilibrées dans le processus d’apprentissage machine. Un biais peut être introduit par les individus concevant les systèmes d’apprentissage de machine learning. Ils peuvent créer des algorithmes qui reflètent des biais cognitifs involontaires ou des préjugés réels. Ils peuvent aussi introduire des biais parce qu’ils utilisent des jeux de données incomplets, défectueux ou préjudiciables pour entraîner ces systèmes. Il en existe plusieurs comme par exemple algorithmique, d’échantillonnage, ou de préjugé. Le premier se produit lorsqu’il y a un problème au sein de l’algorithme alimentant les calculs d’apprentissage machine. Le second se produit lorsque les données d’apprentissage ne sont pas assez vastes ou représentatives. Le dernier se produit lorsque les données d’entraînement reflètent des préjugés, des stéréotypes et des hypothèses sociétales erronées existants, introduisant ainsi ces mêmes biais réels dans l’apprentissage automatique lui-même.

En plus des biais d’entraînement, il y a l’amplification des biais. Le nom de ce phénomène parle de lui-même. En plus de perpétuer un biais, il l’amplifie. Sans entrer dans les détails techniques, tout biais dans les données d’entraînement sera amplifié en raison de la généralisation des données par l’algorithme pour réduire la variance (tendance à apprendre des détails et du bruit aléatoires dans les données d’entraînement). Cela peut conduire à un cercle vicieux de biais et de discrimination, car le modèle devient plus précis en préservant et en amplifiant les biais existants.

L’empoisonnement des données est une attaque qui implique de polluer (ou « d’empoisonner ») les données d’apprentissage, ce qui peut rendre les modèles inexacts et entraîner de mauvaises décisions. C’est une attaque contre l’intégrité car la falsification des données d’apprentissage affecte la capacité du modèle à produire des prédictions correctes. Cela peut avoir de graves conséquences, y compris la désinformation, les escroqueries par hameçonnage, la modification de l’opinion publique, la promotion de contenu indésirable et la discréditation d’individus ou de marques. Comme l’empoisonnement se produit généralement au fil du temps, et sur un certain nombre de cycles d’apprentissage, il peut être difficile de déterminer quand la précision des prédictions commence à changer.

Il existe des solutions pour se prémunir et atténuer ces problèmes, comme la collecte de davantage de données d’entraînement et plus diversifiées, la mise en œuvre de systèmes de validation croisée, le maintien de niveaux élevés de contrôle qualité, etc… Pour aller plus loin, OWASP Top 10 for Large Language Model Applications a publié un guide pour se prémunir des 10 vulnérabilités les plus critiques dans une application utilisant ou mettant en œuvre des LLM.

Maîtrise mieux l’anglais que les autres langues

Un problème particulier avec ChatGPT, qui peut être qualifié de biais d’entraînement, est sa meilleure performance en anglais par rapport à d’autres langues. Il est globalement efficace dans la traduction vers l’anglais, mais moins dans le sens inverse, et encore moins avec des langues non latines. Il éprouve également des difficultés à mélanger plusieurs langues dans un même paragraphe ou une même phrase.

Cette situation est due au fait que GPT a été majoritairement entraîné sur du contenu anglophone, notamment américain. Cela s’explique par la facilité plus grande de trouver du contenu en ligne en anglais plutôt qu’en thaïlandais ou en coréen. Par conséquent, ChatGPT produit des réponses moins pertinentes dans les langues moins représentées. Bien que je sois francophone, j’utilise ChatGPT et les LLM en général presque exclusivement en anglais.

Plagiat et copyright

Les LLM comme ChatGPT peuvent faire du plagiat. Une étude récente de l’Université de Pennsylvanie a mis en évidence que les modèles linguistiques comme GPT-2 produisent plusieurs formes de plagiat, comme de la copie directe ou du paraphrase sans citer l’auteur. Plus la complexité du modèle augmente, plus les plagiats augmentent également. Ces résultats, présentés lors de la Conférence ACM Web 2023, soulignent les défis éthiques de la génération de texte par IA. Les auteurs recommandent la prudence lors de l’utilisation de ces LLM, afin de ne pas s’approprier le travail d’autrui.

Je me souviens, lors de la sortie de ChatGPT, il était possible de lui demander de nous donner des parties de livre. Il était possible d’avoir la quasi-totalité de certains livres de façon gratuite. J’ai réessayé, mais je n’ai pas réussi à reproduire ce comportement. À la place, il est possible de lui demander le résumé du livre ou des chapitres, de quoi il parle ou encore des concepts clés à retenir.

La législation sur le web scraping (technique qui consiste à extraire automatiquement des informations de sites web) par les modèles de langage comme ChatGPT varie entre les États-Unis et l’Europe. Aux États-Unis, scraper des sites publics est généralement accepté, mais peut poser des problèmes de droit d’auteur. En Europe, avec le RGPD et d’autres régulations, le scraping peut rencontrer des défis juridiques, surtout s’il implique des données personnelles. Le droit d’auteur protège les œuvres, non les données brutes, mais leur utilisation peut être problématique.

Concernant la jurisprudence sur la propriété des contenus générés par IA, elle diffère également entre les États-Unis et l’Europe. Aux États-Unis, les œuvres créées par l’IA ne sont pas protégées par défaut par le droit d’auteur, car il n’y a pas d’intervention humaine dans le processus. Cependant, si le contenu généré est suffisamment modifié de façon créative, alors le contenu généré peut justifier une protection. En Europe, la situation est plus complexe en l’absence de législation spécifique. Même si le Parlement européen suggère de reconnaître le propriétaire de l’IA comme auteur, le futur règlement européen sur l’IA pourrait imposer une réglementation stricte sur ces outils.

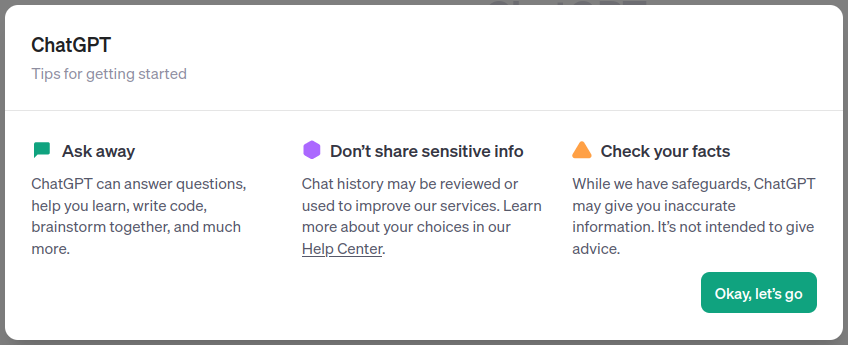

Vie privée

C’est quelque chose que je répète souvent autour de moi : faites attention à ce que vous envoyez à ChatGPT. Peu de gens le savent, mais par défaut, les équipes d’OpenAI ont accès à l’historique de vos conversations. Cet accès sert à vérifier que vous ne faites pas d’usage abusif, mais aussi à améliorer ChatGPT. Cela signifie que si vous envoyez des informations confidentielles ou des données privées, celles-ci peuvent être réutilisées pour l’apprentissage de ChatGPT. Pour éviter tout problème, vous devez bien évidemment faire attention à ce que vous envoyez à ChatGPT, ne pas envoyer de données privées ou confidentielles, anonymiser vos prompts ou encore désactiver l’historique.

Ce n’est pas le seul problème lié aux données privées. Il est possible que les LLM divulguent des informations privées ou confidentielles, cette fois-ci non pas liées à l’entraînement continu, mais à l’entraînement initial. Un pirate informatique attaquant un LLM pourrait tout à fait accéder à ces données d’entraînement et donc à ces données privées. Il pourrait alors s’en suivre des divulgations non autorisées ou le pirate pourrait s’en servir pour faire du chantage, du vol d’identité, etc…

Enfin, le dernier point d’attention sur l’aspect données sensibles est l’utilisation des plugins. Pour le cas de ChatGPT, comme indiqué un peu plus haut, il est possible d’ajouter et d’activer des plugins (si vous avez souscrit à l’abonnement ChatGPT plus). Ces plugins nécessitent pour la quasi-totalité que votre prompt et votre discussion soient envoyés sur un serveur tiers. Le problème est qu’il est probable que vos données transitent par un ou plusieurs réseaux peu ou pas sécurisés ou qu’elles se retrouvent stockées sur un serveur accessible à d’autres personnes. On ne peut pas savoir avec certitude si elles ne seront pas interceptées et lues. Sans tomber dans la paranoïa, je vous conseille de redoubler de vigilance quand vous utiliserez un plugin.

Depuis peu, même ChatGPT vous le spécifie au lancement d’un nouveau chat : Ne partagez pas de donnée sensible et vérifier ce qu’il vous dit.

Plus ils seront intelligents, plus des métiers et des personnes seront remplacées

Les LLM devraient avoir un impact important sur le marché du travail, entraînant à la fois des pertes d’emplois et la création de nouveaux types de postes. On s’attend à ce qu’ils affectent environ 80% de la main-d’œuvre américaine, avec au moins 10 % de leurs tâches de travail potentiellement impactées par ces modèles.

Cela touche tous les niveaux de salaire. Les LLM peuvent automatiser bon nombre de tâches, ce qui pourrait entraîner des pertes d’emplois significatives et le chômage dans plusieurs secteurs, en particulier dans les pays en développement où les emplois intensifs en main-d’œuvre sont prédominants.

L’IA peut également aider les gens à améliorer leur expérience de travail en automatisant les tâches répétitives, ce qui pourrait contribuer à une augmentation des emplois en IA et à une demande accrue de ces compétences. Alors que les LLM pourraient remplacer certains emplois, ils peuvent aussi en créer beaucoup d’autres, rendant les travailleurs plus productifs.

Je pense que les LLM vont d’abord défavoriser les emplois à faible valeur ajoutée et répétitifs, réduisant le besoin de personnel junior, tout en rendant certains emplois à plus fortes valeurs ajoutés et moins répétitifs plus efficaces. Je le vois dans mon quotidien. Pendant que je réfléchis à une implémentation ou à résoudre un problème, mon « assistant » effectue pour moi des tâches répétitives ou basiques, mais beaucoup plus rapidement que moi.

Nous sommes encore loin de remplacer totalement des métiers par un LLM. Sans expertise et un minimum de connaissances, vous ne pourrez pas les utiliser pleinement. Dans le cas d’un ChatBot pour une relation client, celui-ci n’a pas la réponse à tout, et quand c’est le cas, un humain doit prendre le relais. Un autre exemple, pour la création d’un logiciel, certes le LLM peut produire du code, mais il faut savoir quoi en faire, comment l’exécuter, le tester, l’incorporer dans une base de code existante, le déployer, etc.

Attaque par injection de prompt

L’injection de prompt est un nouveau vecteur d’attaque spécifique aux LLM. Il permet à l’attaquant de manipuler le comportement d’un LLM en ajoutant de façon dissimulée des instructions ou du contexte au prompt initial. Pour rappel, le prompt est le texte que vous envoyez au LLM.

Une première façon d’effectuer cette attaque est de dissimuler un nouveau prompt en plein milieu d’un texte, par exemple, un article. Grâce à ce prompt, vous pouvez faire plusieurs choses. Vous pouvez par exemple faire en sorte qu’il dénigre une personne ou véhicule des idées potentiellement douteuses. Vous pouvez aussi faire en sorte que le LLM fournisse de fausses informations ou des instructions dangereuses à suivre. Grâce aux plugins de ChatGPT, du fait que les données transitent par un serveur tiers, vous pouvez aussi faire en sorte que le LLM tente d’extorquer des informations privées comme des coordonnées bancaires. Je pense que c’est une des raisons pour lesquelles ChatGPT avait désactivé l’accès à internet et qu’il vient de le remettre en partenariat avec Bing.

Je ne vais pas rentrer dans les détails techniques, mais si vous voulez en savoir plus, j’ai ajouté des liens en bas de cet article. Sachez que ces techniques existent, et sans tomber dans la paranoïa, soyez attentifs aux réponses du LLM que vous utilisez lorsqu’il accède à une source de données tierce.

Aide les fraudeurs et les pirates informatiques

Le « social engineering », ou ingénierie sociale, est une technique utilisée par les fraudeurs pour manipuler les gens afin qu’ils divulguent des informations confidentielles. L’hameçonnage, qui est une des techniques d’ingénierie sociale, est une fraude en ligne visant à voler vos informations personnelles ou financières par un email.

Les LLM comme ChatGPT peuvent être utilisés pour créer des emails d’hameçonnage de plus en plus convaincants et difficilement reconnaissables par rapport à un email légitime. Même pour une personne ne parlant pas bien une certaine langue, il est maintenant plus facile et rapide que jamais de créer du contenu personnalisé et de bonne qualité. Il devient également aisé de créer des variantes d’un même contenu pour déjouer les systèmes de sécurité et pour tromper plus facilement les humains. Enfin, il devient aussi possible pour ces personnes mal intentionnées d’utiliser de nouvelles techniques plus sophistiquées avec lesquelles elles n’étaient pas familiarisées.

Il en va de même pour la création de fake news. On peut séparer ce problème en deux catégories : les fake news involontaires et volontaires. La première catégorie (involontaire) est liée aux hallucinations (pour rappel, l’invention de faits ou de choses convaincantes, mais complètement fausses). En ne vérifiant pas ou pas bien la véracité de la réponse d’un LLM, vous vous exposez à de la désinformation. La seconde catégorie (volontaire) est la possibilité de générer de fausses informations de façon délibérée. Cela pourrait rendre les campagnes de désinformation plus accessibles et de meilleure qualité.

Une autre façon dont ChatGPT peut aider les pirates informatiques est de faciliter le développement de malwares « polymorphes ». Il s’agit d’un même logiciel malveillant, mais écrit d’une autre manière ou utilisant d’autres techniques, permettant de changer son apparence et sa signature. Cela rend le piratage nettement plus facile pour des individus moins expérimentés. Enfin, il est tout à fait possible de créer des LLM dédiés à ces activités frauduleuses, ou d’améliorer un existant (fine-tuner), pour les rendre encore plus performants.

Impact energétique et environemental

Les LLM et les gros modèles de machine learning en général ont une forte empreinte environnementale en raison de leur consommation énergétique élevée pour le processus d’entraînement ainsi que pour leur utilisation au quotidien.

Quand vous faites une recherche sur le moteur de recherche Google, selon les derniers chiffres officiels de Google datant de 2009 (qui ont évolué dans le bon sens depuis), chaque requête consommerait 0.3 Wh. Cela correspond à la consommation d’une ampoule LED de 10 watts pendant un peu moins de deux minutes. Pour ChatGPT, c’est entre 1,7 et 2,6 Wh (soit entre 5,7 et 8,7 fois plus qu’une requête Google), se traduisant par un coût d’environ 0,2 centime de dollar.

Pour faire fonctionner n’importe quelle application cloud, cela nécessite des datacenter (fermes de serveurs) devant être continuellement refroidis. Ils sont en grande majorité refroidis en utilisant de l’eau fraîche qui en s’évaporant refroidit les serveurs. Un kWh consommé par un serveur nécessiterait 3L d’eau pour le refroidissement. Une cinquantaine de questions/réponses avec ChatGPT consommerait 500 mL d’eau.

En une journée, les milliards de requêtes quotidiennes consommeraient une quantité d’énergie équivalente à 1 GWh, soit en comparaison la consommation quotidienne d’énergie d’environ 33 000 ménages américains. Les émissions de dioxyde de carbone s’élèvent à 8,4 tonnes par an. En comparaison, un aller-retour Paris-New York émet approximativement 1,75 tonnes de CO2.

En plus de cette consommation de ressources quotidienne, l’entraînement des LLM en consomme aussi. Pour GPT-3, il est estimé qu’il aurait fallu :

- 700 000 litres d’eau (en comparaison, une douche moyenne consomme 70 L d’eau et une piscine olympique contient 830 000 L)

- 1300 gigawatts heures (soit environ la consommation de plus de 100 foyers américain moyen pendant une année complète)

- 502 tonnes de CO2 (l’équivalent de l’émission de 110 voitures américaines sur une année complète)

Cela soulève des questions quant à l’utilisation d’un LLM pour des tâches qui sont bien effectuées par d’autres applications et qui ont un impact environnemental plus faible, par exemple :

- Deepl ou Google Translate pour effectuer des traductions ;

- Un moteur de recherche pour effectuer de simples recherches d’information ;

- Bon patron ou LanguageTool pour la correction d’orthographe et grammaticale.

Baisse du trafic d’origine humaine sur certain site

Les LLM peuvent entraîner une diminution du trafic humain sur certains sites web, un phénomène déjà observé. Certains LLM sont directement connectés aux moteurs de recherche et à Internet, effectuant des recherches pour les utilisateurs afin de trouver des sources pertinentes pour produire une réponse synthétique. Cela est le cas, par exemple, avec perplexity.ai ou à la dernière version de ChatGPT.

Dans les cas où les moteurs de recherche où les moteurs de recherche intègrent directement un LLM. Dans ce cas, l’utilisateur effectue sa recherche, mais a tendance à ouvrir moins de sites web, car le LLM intégré lui résume l’information, comme c’est le cas avec Bing. Si le LLM ne cite pas ses sources, l’utilisateur ne peut pas vérifier directement la véracité de la réponse générée, ce qui peut entraîner une baisse de trafic pour les éditeurs de contenu. Même si le LLM cite ses sources, l’utilisateur pourrait considérer l’information comme fiable et ne pas ressentir le besoin de consulter les sites sources.

Les LLM sont entraînés sur des données publiquement accessibles sur Internet. Cela peut entraîner une baisse de la fréquentation de certains sites web si le LLM parvient à répondre à la question de l’utilisateur sans que celui-ci ait besoin de visiter le site source.

Face à cette situation, les éditeurs de contenu pourraient de plus en plus souvent mettre en place des barrières payantes, empêchant les LLM d’accéder à leurs données. Cette stratégie vise à contrecarrer la baisse de trafic tout en maintenant leurs revenus. Cela aurait aussi un effet négatif, limitant l’accès à l’information pour ceux qui ne peuvent pas se permettre de s’abonner.

Par exemple, Reddit a récemment rendu son API payante, alors qu’elle était gratuite auparavant. Une étude a montré qu’après la sortie de ChatGPT, l’activité sur Stack Overflow a significativement diminué, avec une baisse estimée à 16 % des publications hebdomadaires, stabilisée à environ 25 % fin avril 2023. Cependant, Stack Overflow réagit à ce défi en développant ses propres modèles d’IA et en lançant OverflowAI, qui utilise l’IA générative pour répondre automatiquement aux questions de codage des utilisateurs.

Conclusion

Les LLM, tels que ChatGPT, représentent une révolution technologique offrant de nouvelles possibilités, mais également de nombreux défis. Comprendre et être conscient de leurs limites est crucial pour assurer une utilisation éthique et sécurisée. En adoptant proactivement des contre-mesures appropriées, comme présentées tout au long de cet article, nous pouvons assurer que ChatGPT et d’autres LLM continueront à être des outils précieux du quotidien. Rester informé et vigilant face à ces défis est crucial pour maximiser les avantages de ces technologies puissantes.

Sources

- Navigating the Risks of Artificial Intelligence on the Digital News Landscape

- Machine learning bias (AI bias)

- The Future of AI; Bias Amplification & Algorithmic Determinism

- How data poisoning attacks corrupt machine learning models

- A Novel Approach to LLM prompt injection using Genetic Algorithms

- ChatGPT and large language models: what’s the risk?

- Why is maths so hard for LLMs?

- The Power of Context: Understanding the Importance of Context Window in Large Language Models